O primeiro computador quântico comercial do mundo, construído pela empresa D-Wave, foi lançado em 2011. Desde então, várias gigantes da tecnologia, como Amazon, Google, IBM, Intel e Microsoft, assim como outras empresas novas lançaram os seus próprios modelos de computadores quânticos, demonstrando uma contínua evolução em seu poder de processamento. Essas máquinas já vêm sendo usadas para resolver problemas em áreas como finanças, logística e ciência dos materiais.

A expectativa é de que, em mais uma ou duas décadas, os computadores quânticos sejam capazes de desenvolverem melhores medicamentos, fertilizantes, painéis solares e outros materiais, por meio de cálculos impossíveis de serem realizados por um computador clássico. “Serão avanços importantes, e não serão apenas incrementais”, afirma o físico Rodrigo Benevides, pesquisador do Instituto de Física da Universidade de São Paulo (USP). “Estamos falando de saltos de possibilidades.”

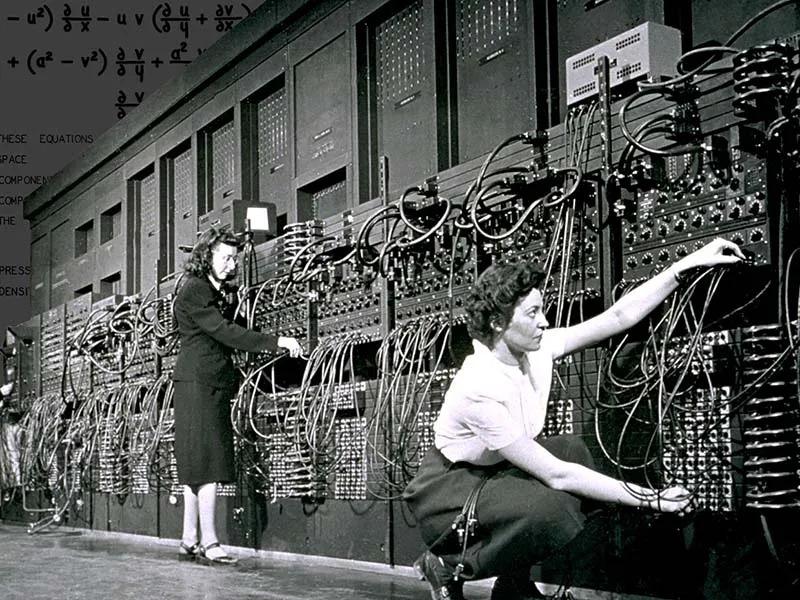

O primeiro computador eletrônico digital do mundo foi o ENIAC. Construído em 1945, na Universidade da Pensilvânia, nos Estados Unidos, o ENIAC pesava 30 toneladas, tinha dois metros de altura e ocupava uma área de 180 metros quadrados. Utilizando 18 mil válvulas termoiônicas, possuía uma memória capaz de armazenar mil palavras de 34 bits — sequências de zeros e uns, codificando informação em uma linguagem binária. Sua capacidade de processamento de informação era inferior ao de uma calculadora de bolso atual.

Em 80 anos, a substituição das válvulas termoiônicas, cujo funcionamento depende da física clássica, pelos transistores, que se baseiam na mecânica quântica, levou ao desenvolvimento de supercomputadores com memórias com cerca de 10 petabits, ou 10 mil trilhões de bits, sendo capazes de processar em torno de 10 exabits, ou 10 milhões de trilhões de bits por segundo.

Existem, porém, muitos problemas importantes que mesmo os melhores supercomputadores atuais não são capazes de resolver. Isso acontece porque, embora os hardwares desses computadores sejam baseados na mecânica quântica, os seus softwares ainda funcionam pelos mesmos princípios do ENIAC, armazenando e processando informação em sequências de zeros e uns.

Em 1981, durante uma palestra no Instituto de Tecnologia da Califórnia (Caltech), nos Estados Unidos, o físico Richard Feynman foi um dos primeiros a chamar atenção para os limites fundamentais dos computadores clássicos. Naquela época, os físicos já usavam computadores para calcular a evolução dos átomos constituintes de moléculas ou de materiais. Acontece que, tanto nos anos 1980, como hoje em dia, essas simulações computacionais só podiam ser realizadas por meio de aproximações, que limitam nosso conhecimento sobre esses sistemas. Isso porque as soluções da equação de Schrödinger para sistemas de muitos corpos podem ser extremamente complexas. Se quiséssemos descrever com um computador clássico, sem aproximações, todas interações possíveis entre um conjunto de apenas 300 átomos, seriam necessários um número de bits maior do que o número de átomos que existem no Universo. Em sua palestra, Feynman concluiu:

Richard Feynman

"Simulating Physics with Computers”. International Journal of Theoretical Physics, vol. 21, no 6, june 1982,

p. 467–88

Ainda em 1981, o físico americano Paul Benioff (1930-2022) começou a aplicar os conceitos da mecânica quântica à ciência da computação. Em 1985, o físico israelense David Deutsch (1953 – ) apresentou o conceito de computador quântico, demonstrando mais tarde, em 1992, com o físico australiano Richard Jozsa (1953- ), um algoritmo quântico que oferecia um ganho exponencial no processamento de informação, em relação a um computador clássico.

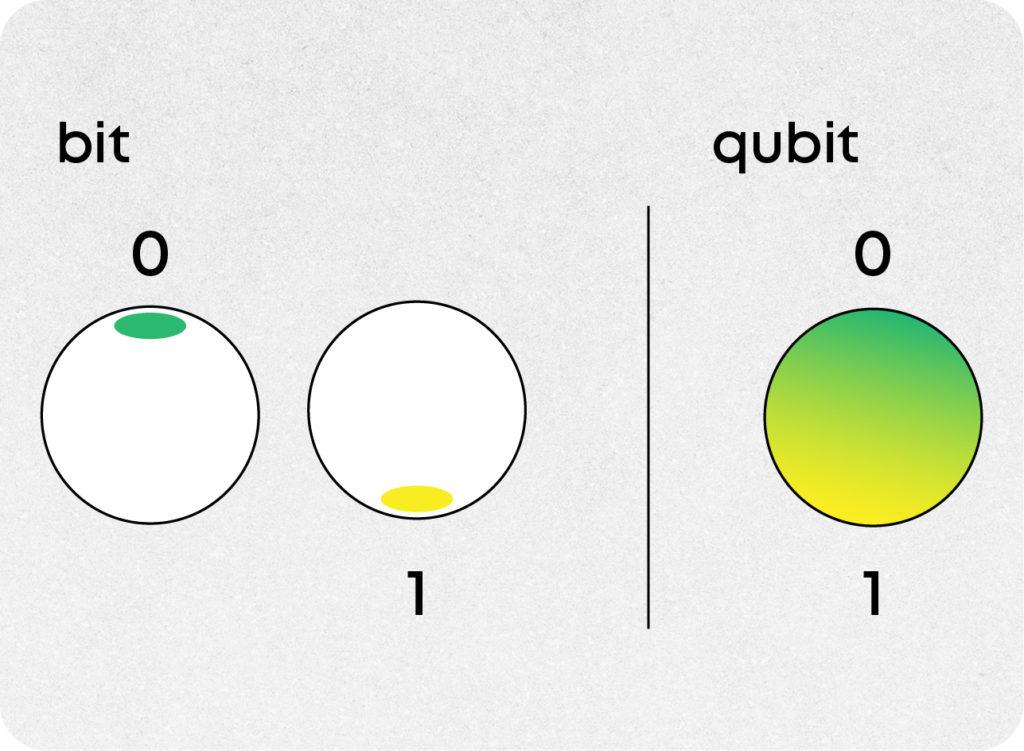

A base do funcionamento de um computador quântico é o chamado bit quântico, ou qubit. Enquanto o bit binário dos computadores clássicos só pode assumir os valores de zero ou um, o qubit pode ser preparado em estados de sobreposição quântica de zero e um. Cada estado sobreposto possível reflete as diferentes probabilidades do qubit ser medido como zero ou como um. Esse contínuo de possibilidades entre zero e um faz com que um qubit possa codificar muito mais informação do que um bit clássico.

Em sua maioria, os bits dos computadores clássicos são codificados nos estados físicos da corrente elétrica em transistores e na orientação magnética de regiões dos materiais usados nas memórias. Com os qubits, porém, a situação é diferente: não existe uma única maneira de construir um computador quântico, e cada abordagem codifica os qubits de forma distinta. Eles podem ser implementados, por exemplo, nos estados quânticos de núcleos atômicos, de correntes em materiais supercondutores, de fótons e de outros sistemas.

Assim como um computador clássico funciona executando algoritmos — sequências de operações lógicas que alteram os estados de seus bits, com o objetivo de resolver algum problema — um computador quântico também executa algoritmos que manipulam os estados de seus qubits. Mas enquanto um computador clássico precisa realizar um cálculo por vez, um algoritmo quântico pode utilizar a sobreposição e o emaranhamento dos qubits para explorar várias possibilidades ao mesmo tempo, resolvendo muitos cálculos em paralelo, o que pode diminuir exponencialmente o tempo de resolução de certos problemas.

Um desses problemas é a decomposição de números em seus fatores primos. Fatorar números pequenos em primos é fácil. O número 15, por exemplo, é igual a 3 vezes 5. Agora, descobrir os fatores primos de números realmente grandes pode ser uma tarefa quase impossível, mesmo para um supercomputador. Encontrar os fatores primos de um número de 512 bits, ou 155 casas decimais, levaria alguns meses. Se o número fosse ainda maior, com 2048 bits (617 casas decimais), o cálculo se estenderia por bilhões de anos.

Em 1994, o cientista da computação norte-americano Peter Shor (1959- ) descobriu um algoritmo que permitiria um computador quântico com alguns milhões de qubits decompor em primos um número de 2048 bits em questão de horas. Desde a sua criação, o algoritmo de Shor tem causado um grande impacto, inspirando o avanço da computação quântica, especialmente pelo seu potencial de afetar a tecnologia mais utilizada atualmente para troca de informações sigilosas na internet (veja Comunicação quântica).

Outro algoritmo quântico importante foi descoberto em 1996, pelo cientista da computação indiano Lev Grover (1961- ). O algoritmo de Grover utiliza estados de sobreposição quântica para acelerar drasticamente a busca por informações em um banco de dados.

Já as primeiras demonstrações experimentais de computação quântica aconteceram no final dos anos 1990, usando a técnica de ressonância magnética nuclear (RMN). Os spins dos núcleos atômicos de moléculas em solução líquida foram usados para produzir dois qubits e executar algoritmos. A técnica de RMN, porém, não permite o aumento de qubits para mais que algumas dezenas, além de possuir outras limitações que restringem sua utilidade a problemas específicos e fins educacionais. Atualmente, a empresa chinesa SpinQ comercializa computadores quânticos de mesa, baseados em RMN, com até 3 qubits. Em 2023, a empresa startup brasileira Dobslit instalou um computador da SpinQ em uma escola do SENAI, em São Caetano do Sul (SP).

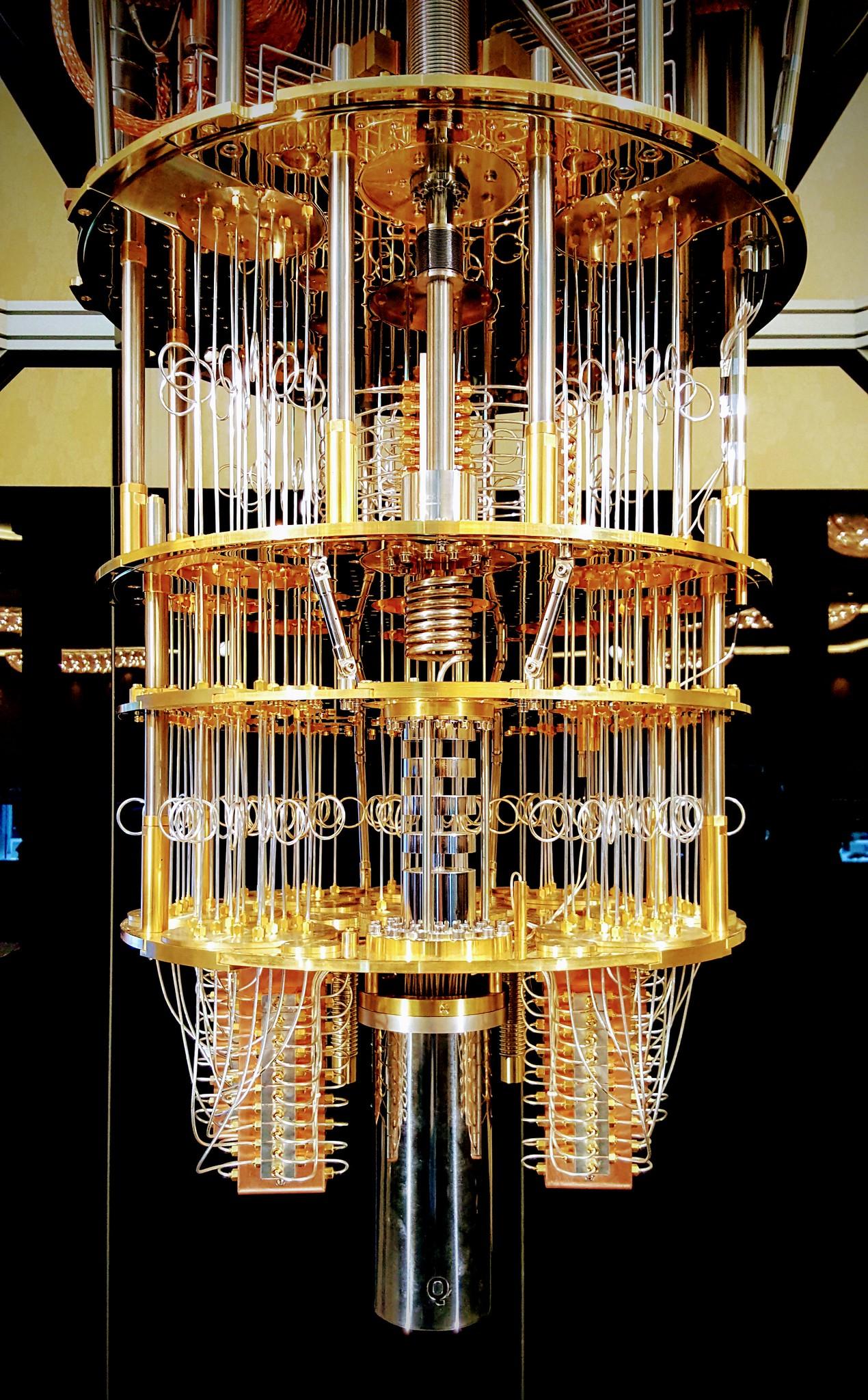

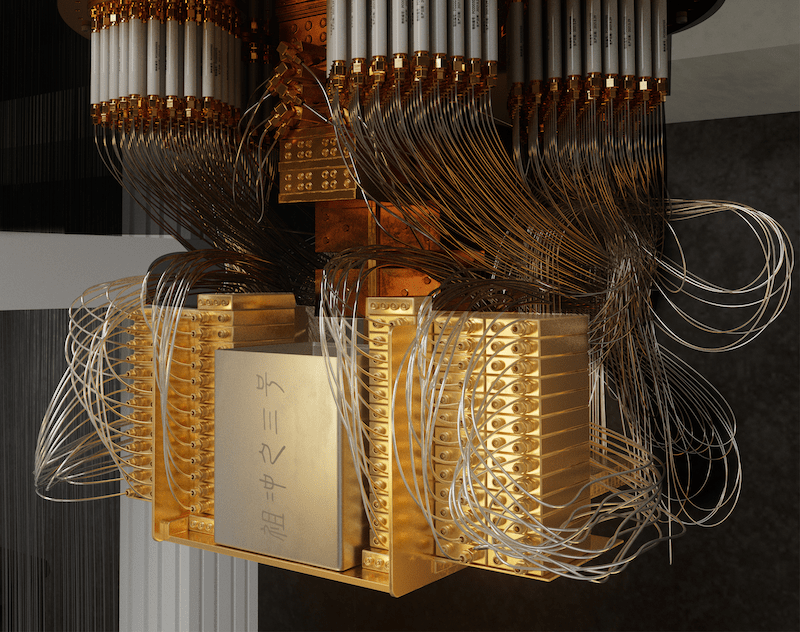

No lugar da RMN, pesquisadores e empresas investiram no desenvolvimento de várias outras plataformas para computação quântica. A mais famosa e uma das mais promissoras é a dos computadores com qubits supercondutores, fabricados por empresas como as norte-americanas IBM , Google e Rigetti. Cada qubit desses computadores é parte de um circuito elétrico supercondutor, que possui dois níveis de energia, cada um representando zero ou um. Os estados quânticos dos qubits são controlados por meio de pulsos de microondas. Essas máquinas só funcionam quando resfriadas a temperaturas extremamente baixas, próximas de −273 °C. Essas temperaturas são obtidas por meio de dispositivos chamados de refrigerador de diluição, que possuem um formato curioso, que lembra um enorme lustre, cheio de fios (fotografias desses refrigeradores nos sites de notícia já viraram sinônimo de computação quântica). Em 2023, a IBM lançou o seu chip Condor, o maior processador quântico supercondutor já fabricado, com 1.121 qubits.

Em 2019, uma equipe de pesquisadores da Google usou o Sycamore, um chip com 53 qubits supercondutores, para realizar um problema matemático abstrato — uma certa geração de distribuições aleatórias de números. O Sycamore resolveu o problema em cerca de três minutos, enquanto o supercomputador Summit, da IBM, levou dois dias e meio. O feito foi celebrado como o início da “supremacia” ou vantagem quântica sobre os computadores clássicos.

Empresas como a IBM e a Google estão construindo chips para operarem como um computador universal, isto é, uma máquina capaz de executar toda espécie de algoritmo. Outras empresas, como a canadense D-Wave, perseguem uma abordagem diferente, construindo dispositivos capazes apenas de resolverem uma classe de problemas específicos. O mais recente computador quântico supercondutor da D-Wave, o Advantage2, possui 4.400 qubits. Ele utiliza um método específico de computação quântica, chamado de recozimento quântico, para encontrar as melhores soluções para problemas que possuem um grande número de possibilidades. Um exemplo desse tipo de problema de otimização é a movimentação de caminhões e de contêineres no Porto de Los Angeles, o mais movimentado dos Estados Unidos. Em 2018, a D-Wave usou seu computador quântico, em colaboração com um sistema de inteligência artificial, para aumentar a eficiência da movimentação no porto em 60%.

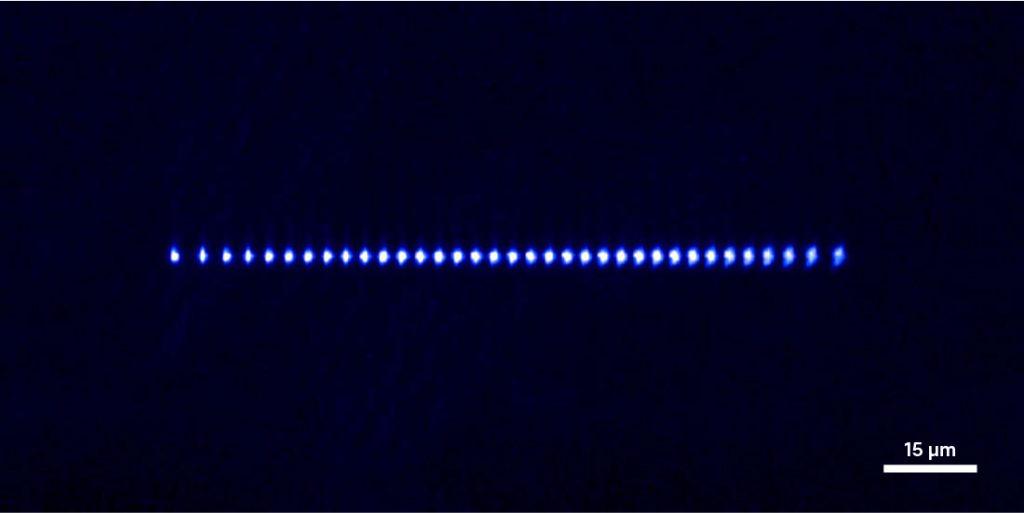

Outra plataforma para a computação quântica muito explorada é a dos íons aprisionados. Íons são átomos eletricamente carregados por falta ou excesso de elétrons. Esses íons são aprisionados individualmente em armadilhas eletromagnéticas e resfriados por feixes laser. Os íons podem ser dispostos em uma fileira ou em outros arranjos espaciais. Um qubit é o estado de dois níveis de energia de um elétron do íon. Os estados dos íons são controlados por lasers, assim como a interação entre eles, para gerar estados de sobreposição e emaranhamento. As empresas americanas IonQ e Quantinuum são as líderes mundiais nesses sistemas, produzindo computadores quânticos de íons aprisionados com respectivamente 30 e 56 qubits.

Uma tecnologia similar é a baseada em átomos neutros, como os das empresas americanas QuEra e Atom Computing. Seus qubits são átomos de Rydberg, nos quais o elétron mais afastado do núcleo atômico se encontra em um nível de energia muito alto e sensível a outros átomos próximos. Lasers são usados para resfriar os átomos e os arranjarem em uma rede bidimensional, onde suas interações podem ser controladas. O processador mais recente da QuEra possui 256 qubits, enquanto o da Atom Computing chega a 1.225 qubits.

Tanto os computadores de íons aprisionados, quanto os de átomos neutros são particularmente adequados para realizar simulações quânticas de átomos em materiais. Pesquisadores utilizando esses computadores já conseguiram revelar detalhes de interações magnéticas dentro de materiais que um supercomputador clássico demoraria um tempo longo demais para descobrir.

Enquanto isso, a empresa da americana PsiQuantum e a canadense Xanadu desenvolvem computadores quânticos baseados em luz. A Psiquantum usa fótons individuais como qubits, que percorrem um circuito de silício. Enquanto isso, os qubits da Xanadu são codificados na fase e na amplitude de ondas eletromagnéticas, preparadas em estados quânticos especiais chamados de estados comprimidos. Essas ondas realizam computação atravessando um circuito de fibras ópticas. Em 2022, a Xanadu anunciou ter atingido uma vantagem quântica, ao resolver um problema conhecido com amostragem de bósons em 36 microssegundos, enquanto um supercomputador clássico levaria horas para calcular. No momento, esses computadores são úteis para resolver problemas específicos, como a simulação de reações químicas e de propriedades de materiais.

Existem ainda grupos de pesquisadores e empresas, como a americana Intel e a australiana Diraq, que perseguem o desenvolvimento de computadores quânticos baseados em elétrons no silício, da mesma maneira que funcionam os computadores clássicos. Seu objetivo é utilizar todo o conhecimento acumulado em décadas pela indústria de fabricação de microchips de silício para aumentar rapidamente o número de qubits.

Grandes obstáculos, porém, ainda precisam ser superados.

Belita Koiller

Professora do Instituto de Física da Universidade Federal do Rio de Janeiro (UFRJ) e coordenadora do Instituto Nacional de Ciência e Tecnologia de Informação Quântica (INCT-IQ)

No momento, cada tipo de qubit tem suas vantagens e desvantagens. Em geral, os qubits de íons aprisionados, átomos neutros e fótons são mais isolados do meio ambiente, mantendo por mais tempo a coerência quântica de seus estados do que os qubits supercondutores. Já as operações com qubits supercondutores são bem mais rápidas do que nas outras plataformas.

Rafael Chaves

Físico da Universidade Federal do Rio Grande do Norte (UFRN)

De qualquer forma, ainda estamos longe de ter os computadores quânticos com milhões de qubits, que seriam necessários para executar com eficiência algoritmos como os de Shor e de Grover. Os obstáculos são muitos, e não estão apenas na dificuldade de aumentar o número de qubits.

Celso Villas-Bôas

Físico da Universidade Federal de São Carlos (UFSCAR)

“As propostas de hardware quântico ainda estão no estágio ENIAC”, avalia Koiller. “Elas têm baixa capacidade de processamento e ocupam volumes significativos.”

Todas as tecnologias de computação quântica atuais ainda se encontram em um estágio conhecido pelos pesquisadores como era NISQ, uma sigla em inglês para era “quântica ruidosa de escala intermediária”.

Felipe Fanchini

Físico da Universidade Estadual Paulista (Unesp), campus Bauru

Para que as tecnologias possam avançar, os pesquisadores precisam aprimorar, entre outros detalhes, o controle dos qubits individuais.

Felipe Fanchini

Físico da Universidade Estadual Paulista (Unesp), campus Bauru

Para diminuir a ação do ruído são necessárias as chamadas técnicas de correção quântica de erros. Semelhantes às técnicas de correção de erros dos computadores clássicos, essas técnicas funcionam usando grupos de vários qubits para codificar uma mesma informação de maneira repetida. Assim, um conjunto de muitos qubits físicos representa um único qubit lógico. “Usando essas redundâncias, você consegue detectar e corrigir erros durante a computação”, diz Fanchini.

Além da correção, são necessárias técnicas de mitigação de erros, que funcionam após a computação. Entendendo como os erros acontecem, a mitigação permite ajustar os resultados da computação, para que sejam mais exatos. “Na atualidade, o desenvolvimento mais crítico para computação quântica são essas técnicas de correção e mitigação de erros”, afirma Fanchini.

A correção de erros tem sido a protagonista nos avanços mais recentes da computação quântica. Em dezembro de 2024, uma nova estratégia para correção de erros foi demonstrada pelo Willow, o chip de 105 qubits supercondutores da Google. Em geral, quanto mais qubits são adicionados a um processador, mais erros são introduzidos. Com a estratégia chamada de código de superfície, os pesquisadores demonstraram uma redução exponencial de erros, à medida que acionavam mais qubits do processador.

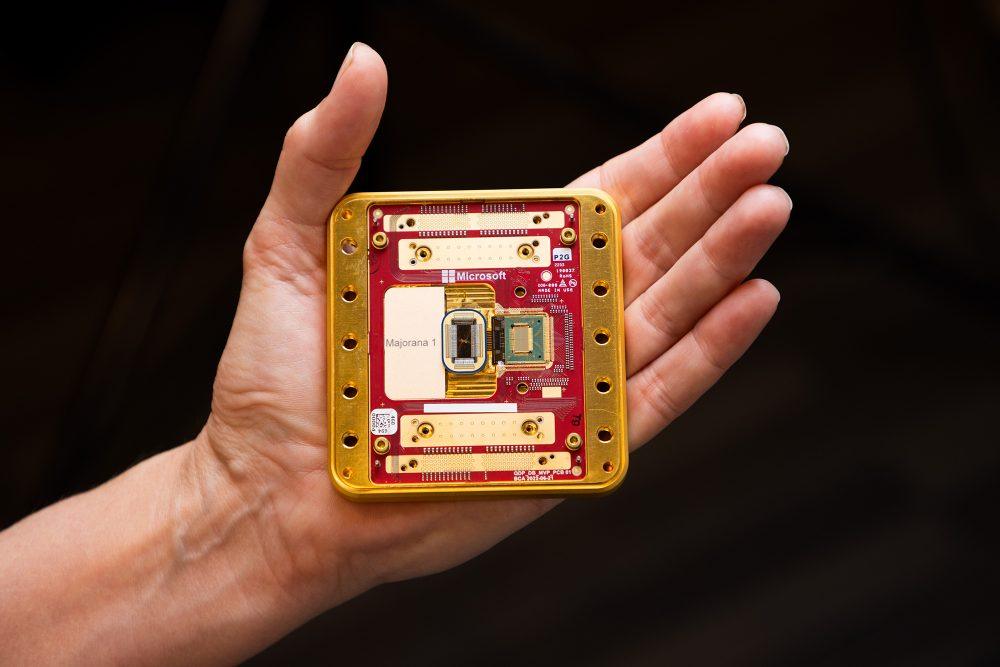

Em fevereiro, a Microsoft anunciou o Majonara 1, um novo computador quântico supercondutor, com uma estrutura diferente, baseada nos chamados qubits topológicos, que seriam muito mais estáveis e resistentes a erros do que outros tipos de qubits. A equipe da Microsoft, porém, não apresentou dados o suficiente para convencer a comunidade científica.

Ainda em fevereiro, a Amazon apresentou o seu chip Ocelot, um processador quântico baseado em fótons em cavidades supercondutoras. Com desenvolvimento liderado pelo físico brasileiro Fernando Brandão, do Caltech, o Ocelot utiliza um novo tipo de qubit, chamado de qubit gato, que suprime um certo tipo de erro, reduzindo em até 90% o número de qubits físicos necessários para se constituir um qubit lógico.

Em março, uma equipe liderada pelo físico Jian-Wei Pan, da Universidade de Ciência e Tecnologia da China, apresentou seu mais recente computador quântico supercondutor, o Zuchongzhi 3.0. Com 105 qubits, o Zuchongzhi 3.0 demonstrou uma performance semelhante ao Willow, da Google. Agora, os pesquisadores chineses planejam implementar as técnicas de correção de erros do Willow em seu chip.

Reportagem: Ana Luiza Sério (ICTP-SAIFR) e Igor Zolnerkevic (ICTP-SAIFR);

Texto: Igor Zolnerkevic (ICTP-SAIFR);

Revisão: Ana Luiza Serio (ICTP-SAIFR) e Larissa Takeda (ICTP-SAIFR);

Consultoria Científica: Gustavo Wiederhecker (UNICAMP) e Marcelo Terra Cunha (UNICAMP);

Projeto gráfico, interatividades e edição multimídia: Victoria Barel (ICTP-SAIFR)